Der Kunde hat beschlossen, seine vertraulichen Daten zu schützen

Ein Datenfluss-Optimierungskatalog für eine Bank

Kundeninformationen

Andersens Kunde ist ein Bankinstitut, das Finanzdienstleistungen anbietet und aktive Marktforschung betreibt.

![[object Object] on the map](https://static.andersenlab.com/andersenlab/new-andersensite/bg-for-blocks/about-the-client/switzerland-desktop-2x.png)

Projektdetails

In diesem Geschäftsfall war unser Kunde ein Bankinstitut, das Finanzdienstleistungen anbietet und aktive Marktforschung betreibt. Unser Auftrag bestand darin, ein internes Suchsystem zu entwickeln, das dem Kunden ermöglicht, durch eine Vielzahl von Unterlagen zu navigieren, darunter technische Dokumente, Artikel aus Finanzzeitschriften, Anweisungen und operative Akten. Die größte Herausforderung bestand darin, dass die Dokumente über einen langen Zeitraum in verschiedenen - auch lokalen - Repositories gespeichert waren, was ihre Auffindbarkeit erschwerte.

Projektumfang

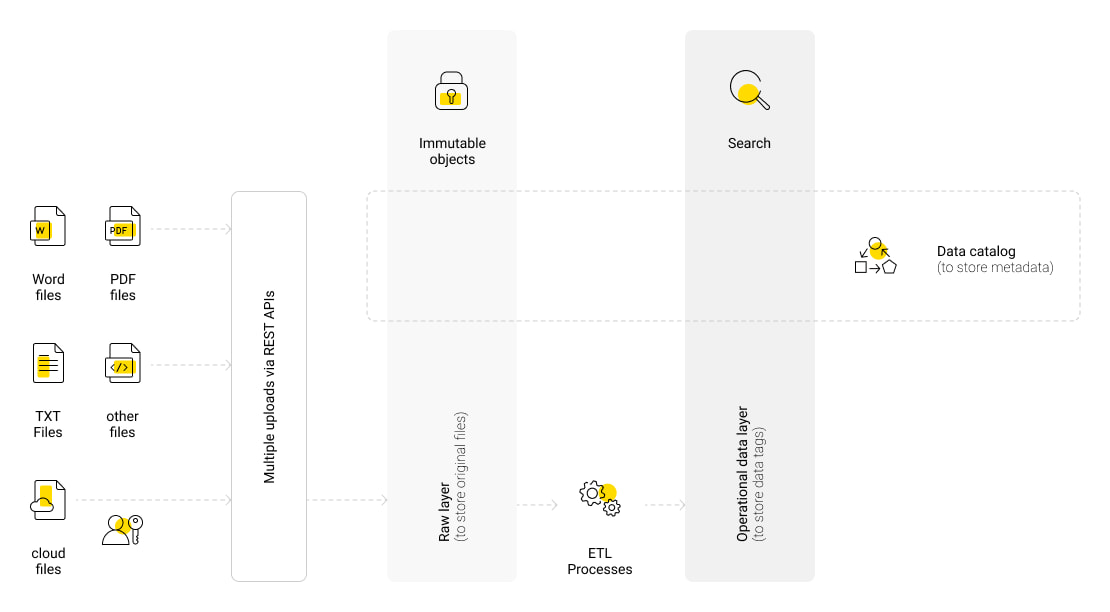

Das logische Diagramm der Wissensaustauscharchitektur

Die Herausforderung des Kunden bestand darin, dass seine enorme Sammlung von Dateien in verschiedenen Formaten (Word, PDF, TXT, Cloud usw.) gespeichert war und daher schlecht strukturiert war. Der Kunde plante, seine Kapazitäten zu verzehnfachen, und benötigte daher dringend IT-Unterstützung. Bei raschem Wachstum könnte die chaotische Datenspeicherung zu einer ernsthaften Bedrohung werden.

Unser Team hat eine Lösung vorgeschlagen, bei der alle Daten in einem einheitlichen Technologie-Stack zusammengeführt werden. Dadurch ist es möglich, Dateien über REST-APIs auf der Rohdatenschicht zu laden, wobei die Unveränderlichkeit eine Schlüsselfunktion ist. Anschließend werden die Dateien in das Repository hochgeladen und einer ETL-Verarbeitung unterzogen. Die operative Datenschicht generiert eine Liste von Tags, Lexemen und Terminologie, die für die Suche verwendet werden sollen.

Unser Ansatz kann sowohl auf den Servern des Kunden als auch in der Cloud umgesetzt werden.

Ein zweistufiger Datenkatalog ist verfügbar. Er fungiert als Speicherdienst für Konfigurationsmetadaten und enthält einen Suchpfad für die Rohdatenschicht. Dadurch können die Daten entsprechend der Terminologie in der Betriebsdatenschicht zugeordnet werden.

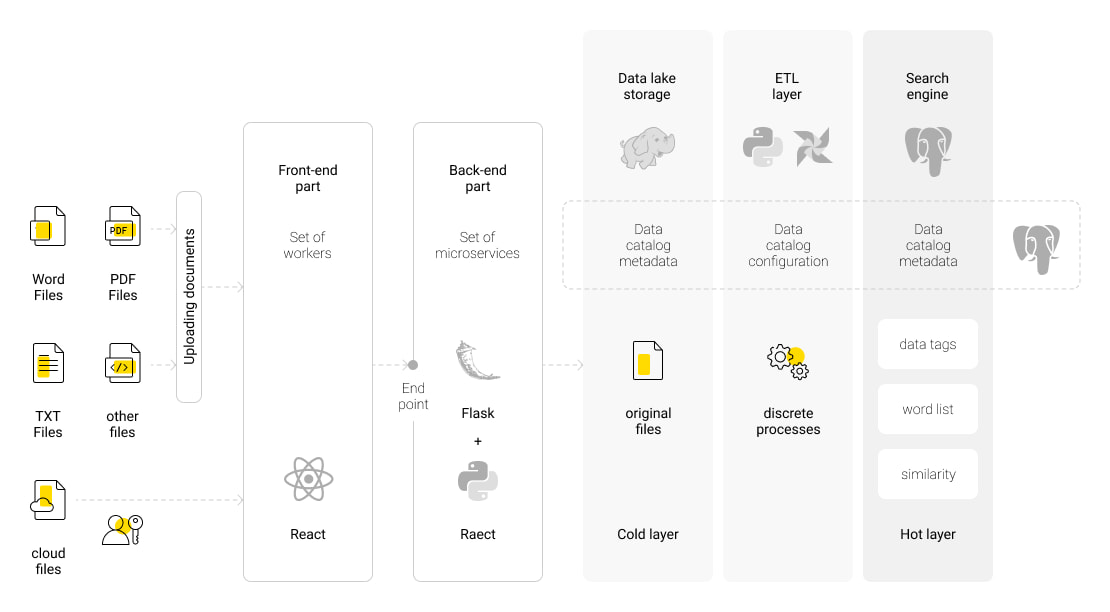

Physisches Layout der Wissensaustausch-Architektur

Das Back-End wurde mit Flask und Python entwickelt, während React für das Front-End verwendet wurde. Das Hadoop-Ökosystem wurde für die kalte Schicht gewählt, und Python sowie Apache Airflow kamen in der ETL-Schicht zum Einsatz. Diese Schicht ist dafür verantwortlich, Dateien zu scannen und den Wert von Tokens und Lexemen in ihnen zu berechnen.

Anschließend wurde in der heißen Schicht eine Liste von Wörtern, Ähnlichkeiten zwischen Dokumenten, Daten-Tags usw. erstellt. Diese Schicht wird durch eine PostgreSQL-Datenbank repräsentiert.

Es gibt eine Metadaten-Katalogdatenbank, die je nach Schicht verschiedene Funktionen erfüllt:

- Die kalte Schicht speichert Informationen über die Adressen der Originaldateien im Hadoop-Ökosystem;

- Die ETL-Schicht implementiert die Konfiguration für Python und Apache Airflow, die diese Dateien verarbeitet und ein Verständnis für ihren Inhalt (Stoppwörter, den Wortnormalisierungsprozess usw.) bietet;

- Die heiße Schicht enthält Informationen darüber, wie Suchanfragen für die Originaldateien in diesem Ökosystem zugeordnet werden können.

Außerdem haben wir einen Satz von Servern für die Hadoop-Speicherung und einen Satz von Servern für den Datenkatalog erstellt.

Architektur

Physisches Layout der Wissensaustausch-Architektur

Andersens Team hat sich dafür entschieden, dass SQL-Anfragen die optimale Lösung in diesem Geschäftsfall sind. Der Grund für diese Entscheidung war, dass die Benutzer auf diese Weise über eine API mit dem Repository interagieren konnten, ohne die React-Engine nutzen zu müssen.

Durch React ermöglicht die Benutzeroberfläche dem Endbenutzer, mithilfe der Suchleiste die benötigten Elemente zu finden.

Nach Eingabe eines Wortes oder einer Phrase erhält der Benutzer eine Tabelle mit Links zu den Originaldokumenten, die im Hadoop gespeichert sind. Durch Klicken auf jedes Dokument kann es heruntergeladen werden.

Das Ergebnis ist eine schnelle Informationsbeschaffung in weniger als einer Sekunde.

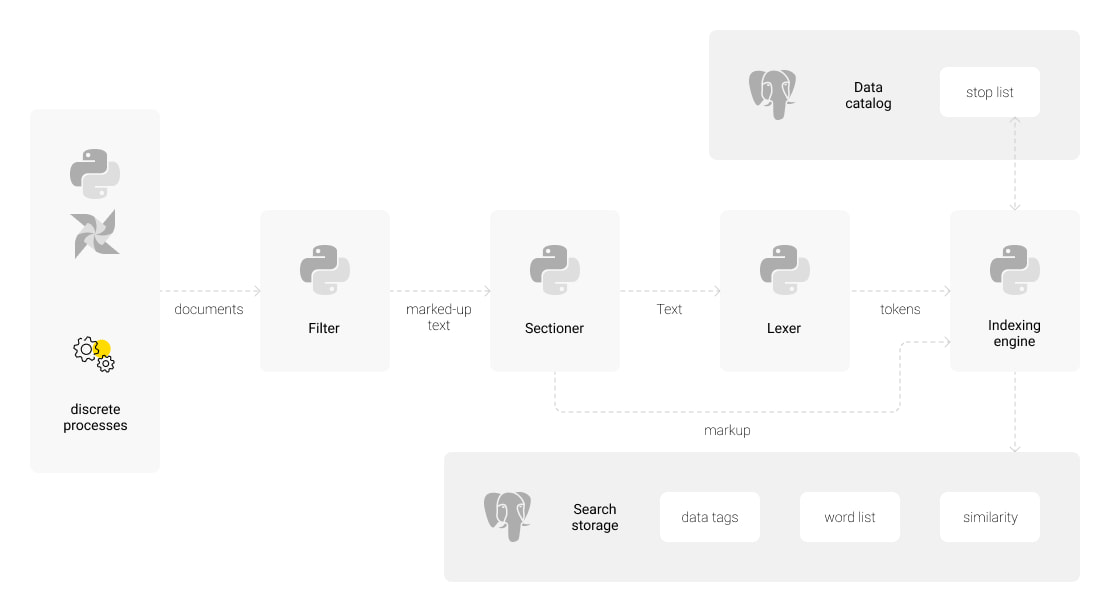

Das physische Schema der Architektur für den Wissensaustausch

Das folgende Diagramm beschreibt den ETL-Prozess.

Für die Umsetzung dieser Lösung haben wir uns für Python entschieden, da es eine beeindruckende Datenbank von Bibliotheken zur Arbeit mit Texten bietet, einschließlich Parsing und Vokabularnormalisierung.

Im Datenkatalog ist eine Stop-Liste zu finden. Sie speichert Wörter, die nicht zu einem bestimmten Domänenfeld gehören.

Projektergebnisse

Unsere Experten haben einen Datenkatalog entwickelt, der folgende Vorteile bietet:

- Der Datenfluss-Optimierungskatalog reduziert die Antwortzeit bei der Informationssuche auf eine Sekunde;

- Das neue interne Suchsystem hat die Benutzerzufriedenheit auf 97 % gesteigert;

- Andersens Team hat sichergestellt, dass die Lösung ohne Datenchaos auf das Zehnfache skaliert werden kann;

- Die benutzerfreundliche API und Oberfläche erleichtern die Interaktion und das Abrufen von Dokumenten erheblich.

Kostenlose Beratung anfordern

Weitere Schritte

Nachdem wir Ihre Anforderungen analysiert haben, meldet ein Experte bei Ihnen;

Bei Bedarf unterzeichnen wir ein NDA, um den höchsten Datenschutz sicherzustellen;

Wir legen ein umfassendes Projektangebot mit Kostenschätzungen, Fristen, CVs usw. vor.

Kunden, die uns vertrauen: